英伟达为何能继续一骑绝尘英伟达、AMD和收入周期性|GPU市场纵览[color=var(--color-primary-themed)][color=var(--print_on_web_bg_color, var(--color-primary))]徐老猫

[color=var(--color-secondary-themed)]2024年2月27日

[color=var(--print_on_web_bg_color, var(--color-primary))][url=][color=var(--color-secondary-themed)]4

[/url]

[color=var(--print_on_web_bg_color, var(--color-primary))][color=var(--color-secondary-themed)]2

[color=var(--print_on_web_bg_color, var(--color-primary))][url=][color=var(--color-secondary-themed)]Share

[/url]

[color=var(--print_on_web_bg_color, var(--color-primary))]一个小通告:考虑到推特限流substack,我曾用rayresearch.blog覆盖于substack之上,但依然限流而且有诸多问题。所以此域名停用,望周知。 [color=var(--print_on_web_bg_color, var(--color-primary))]现仍恢复原域名raycat.substack.com,可到我推特主页链接打开。谢谢大家。 [color=var(--print_on_web_bg_color, var(--color-primary))]老猫美股研究 is a reader-supported publication. To receive new posts and support my work, consider becoming a free or paid subscriber.

[color=var(--print_on_web_bg_color, var(--color-primary))]Upgrade to paid

[color=var(--print_on_web_bg_color, var(--color-primary))]此文是我编译的对GPU市场的综述性文章,原文文后。希望通过此文全景式了解GPU市场的竞争现状以及理解英伟达地位难以撼动的原因。此文发表于近2个月前,就最近英伟达的暴涨来说,它对行业和英伟达竞争优势的分析比较准确。 [color=var(--print_on_web_bg_color, var(--color-primary))]当前的AI培训热和随后的推理市场

[color=var(--print_on_web_bg_color, var(--color-primary))]我们目前正处于对AI的大规模资本支出繁荣中。构建最好LLM的竞争动力(数据量、质量、模型大小和计算能力的综合考量),导致了对更大GPU计算集群的需求。 [color=var(--print_on_web_bg_color, var(--color-primary))]

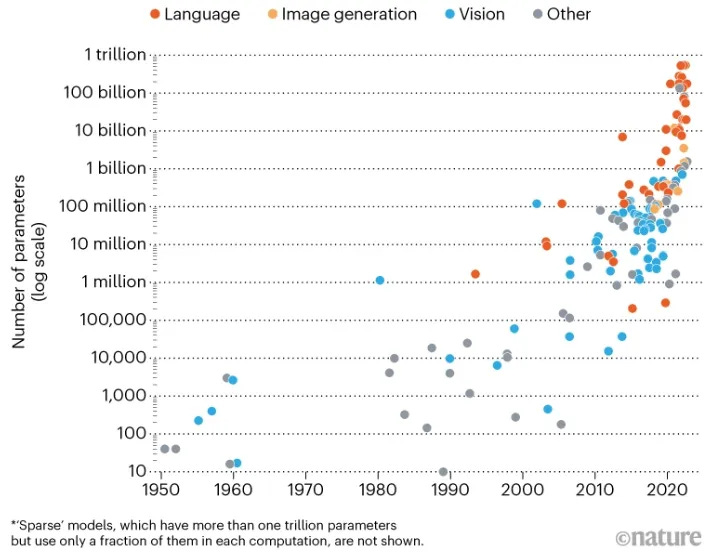

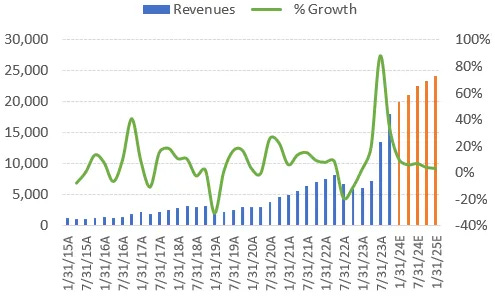

[color=var(--print_on_web_bg_color, var(--color-primary))]来自Nature的数据显示,从参数量衡量的模型大小来看,即使是在对数刻度上,每个领先LLM模型的参数数量以指数级增加。GPT4估计运行1.8万亿个参数,在2.5万个英伟达A100上,训练时间超过三个月。1万到2.5万个GPU的训练集群现在已很常见。比如特斯拉正在大约1万到1.4万个GPU集群上训练FSD系统,马斯克为其AI创业公司购买了类似数量的GPU,也已经发布了Grok首个测试版。 [color=var(--print_on_web_bg_color, var(--color-primary))]一个关键问题是这个资本支出高峰将持续多久。众所周知,基础设施投资具有周期性,半导体不例外。纵观英伟达最近的历史,收入通常会持续6-8个季度的增长,然后进行周期性调整,用1-2个季度找到底部。在向下调整的季度,收入往往会环比下降20%-30%。因此华尔街预测英伟达的收入继续增长5个季度是有依据的。 [color=var(--print_on_web_bg_color, var(--color-primary))]

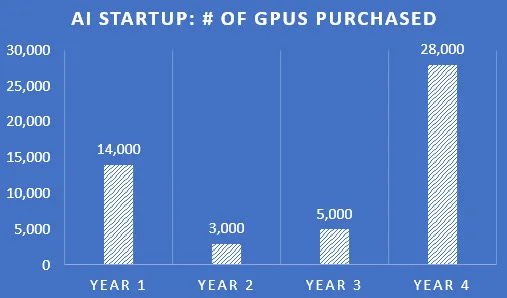

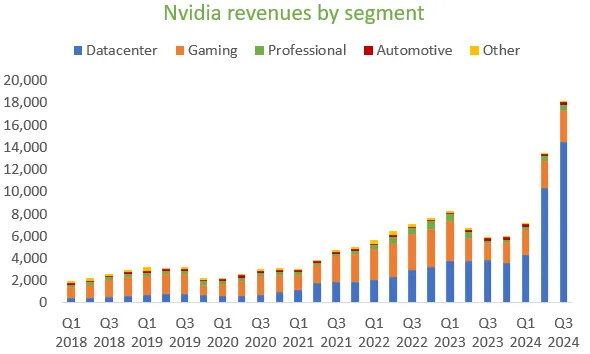

[color=var(--print_on_web_bg_color, var(--color-primary))]在英伟达的前一季度,需求主要来自大型云和互联网巨头。最新季度即2024年Q3,虽然这块需求持续环比增长,但收入来源显得更多元化,比如来自其他类型的企业和来自政府的收入。英伟达CFO如此解释: [color=var(--print_on_web_bg_color, var(--color-primary))]“消费互联网公司和各类企业在Q3推动了突出的环比增长,约占数据中心业务的一半收入,超过了总体增长。像Meta这样的公司已经全面投入使用深度学习推荐系统,并且在尝试用生成式AI来帮助广告商优化图像和文本。 [color=var(--print_on_web_bg_color, var(--color-primary))]企业采用AI的浪潮现已开始。Adobe、Databricks、Snowflake和ServiceNow等企业软件公司正在增加AI智能助手,更多企业正在开发适用于垂直行业的AI应用,比如特斯拉的FSD自动驾驶功能。 [color=var(--print_on_web_bg_color, var(--color-primary))]云服务提供商大约贡献了数据中心收入的另一半。所有超大规模云服务商,以及越来越多专用GPU的云服务商,需求都很强劲。 [color=var(--print_on_web_bg_color, var(--color-primary))]英伟达H100 GPU实例几乎在每个云服务平台都有。今年我们大幅增加了供应,以满足强劲的需求,明年将继续如此。” [color=var(--print_on_web_bg_color, var(--color-primary))]最后一句话至关重要,因为他明确表示2024年会继续增加供应,显然这是很乐观的预期。 [color=var(--print_on_web_bg_color, var(--color-primary))]我们同时也要认识到,即便是行业巨头如英伟达,也很难判断三、四个季度后的市场需求会是什么样子。半导体公司通常会给出乐观的前景,直到有一天他们突然通知你,下一季度将下降30%。现在英伟达的估值中有多大程度已经考虑到这个周期性因素了? [color=var(--print_on_web_bg_color, var(--color-primary))]我们需要问的关键问题仍然是:目前的算力竞赛将持续多久?合理的推测是如下这张有关AI培训支出的图。 [color=var(--print_on_web_bg_color, var(--color-primary))]

[color=var(--print_on_web_bg_color, var(--color-primary))]第一年大量支出,第二年和第三年有一些更新替换和有限的扩展;如果项目成功,则第四年会有一笔更大的巨额支出用于更新和扩大基础设施。如果这个推测是正确的话,英伟达的收入应该会有很大的周期性。 [color=var(--print_on_web_bg_color, var(--color-primary))]和AI培训市场相比,推理市场会大很多。在推理市场这块,GPU将完全根据需求来安装,从而由此产生的收入更稳定,收入增长应该与AI软件产生的收入同步。 [color=var(--print_on_web_bg_color, var(--color-primary))]将英伟达当前出货量与全球已安装计算能力进行比较,可以让我们估算其收入还能继续增长多久。大约15%的已安装计算能力得到加速也许是现实的。当然这个数字还有很大的上调空间,因为LLM模型在提高生产力上有着巨大潜力。 [color=var(--print_on_web_bg_color, var(--color-primary))]英伟达的数据中心业务目前每年产生680亿美元收入。据粗略估计,基于全球已安装的服务器计算能力,每年出货的英伟达数据中心GPU的渗透率约为2.7%-6.8%。英伟达当前的销售额仍然非常有限。 [color=var(--print_on_web_bg_color, var(--color-primary))]如果LLM成为日常工作负载的重要组成部分,例如随着AI助手和生成式AI的兴起,随着推理需求的不断增长,英伟达的收入在未来几年应该会继续高速增长。 [color=var(--print_on_web_bg_color, var(--color-primary))]简而言之,乐观的情况是,虽然随着AI训练用的GPU资本支出呈现繁荣,英伟达收入增长已经非常惊人。随着推理市场的发展,未来几年英伟达会继续增长。 [color=var(--print_on_web_bg_color, var(--color-primary))]悲观的情况则是推理需求令人失望,我们会在4-6个季度内看到常规的周期性修正。对英伟达进行估值时需要考虑到不同的可能性。 [color=var(--print_on_web_bg_color, var(--color-primary))]英伟达保持领先的战略

[color=var(--print_on_web_bg_color, var(--color-primary))]为了保持竞争优势,英伟达继续在硬件和软件两方面创新。首先,该公司将以一年为周期发布新的数据中心GPU(下图)。A100和H100版本之间隔了两年。不过现在每年都会发布新的旗舰架构,其中B100将于今年发布,X100将于25年发布。在此期间,还将发布具有更高带宽内存的H100升级版H200。这种快速迭代的一个关键原因是AI方法在快速发展,这就需要其芯片不仅要更强大,还需要适应新型的工作负载。 [color=var(--print_on_web_bg_color, var(--color-primary))]

[color=var(--print_on_web_bg_color, var(--color-primary))]英伟达还将发布GH200,将GPU和基于ARM的强大CPU置于同一主板上。 H200和GH200均采用先进的CoWoS封装技术,将芯片并排互连成一个功能模块。由于这种技术使供应受限,这也是英伟达去年无法满足GPU需求的主要原因,因此还将发布一款不需要CoWoS封装的功能较弱的L40S。这个GPU功能强大,足以进行AI模型微调和推理,所以需求应该很充足。 [color=var(--print_on_web_bg_color, var(--color-primary))]GH200由1个72核基于ARM的英伟达CPU(名为Grace)和1个H100 GPU(Hopper)组成。总内存非常大,480GB RAM以及96GB或141GB的HBM(具体取决于版本),总共提供约600GB的快速访问内存。通信通过NVLink进行,每秒900GB的带宽。 [color=var(--print_on_web_bg_color, var(--color-primary))]GPU迭代速度增加的另一个主要原因,是英伟达能够对驱动芯片的软件进行更快更新。软件更新可以带来显著的性能改进,甚至可以提高20%以上。 [color=var(--print_on_web_bg_color, var(--color-primary))]目前已经充分讨论过软件在AI领域的作用,英伟达如何凭借其CUDA计算平台以及如何集成了基于Python/C++的训练库(如Tensorflow和Pytorch),从而获得比其他公司领先十多年的优势。竞争对手正在缓慢而不懈地追赶。例如AMD的竞争性ROCm平台在Linux上有Pytorch的本地支持,但在Mac或Windows上还没有。CUDA现在也得到了Python的pandas(数据预处理的关键软件库)以及Apache Spark(数据流的主要库)的支持。 [color=var(--print_on_web_bg_color, var(--color-primary))]黄仁勋在Q3的电话会议上谈到了这一点: [color=var(--print_on_web_bg_color, var(--color-primary))]“在训练模型之前,你必须整理数据,也许必须使用合成数据来增强数据,清理并进行标准化。所有这些数据均以TB和PB为单位。数据处理量非常大,可能占到最终工作量的30%-50%。我们加速Spark,加速Python。我们做的最酷的事情之一就是cuDF pandas,无需一行代码,pandas现在就可以通过开箱即用的CUDA进行加速。” [color=var(--print_on_web_bg_color, var(--color-primary))]英伟达的最后一个优势是他们能够将所有这些硬件和软件集成到一个完整的堆栈中,从而可以轻松地在数据中心内推出AI加速功能。英伟达有GPU,也有CPU、Mellanox(网络业务包括Infiniband和以太网),然后是无数的软件包,让一切变得易于使用。黄仁勋在Q3电话会议上讨论了这一点: [color=var(--print_on_web_bg_color, var(--color-primary))]“英伟达存在于每个云中,每个平台虽然很不相同,但我们已集成到他们的所有堆栈中。配合得非常好,包括我们建的所有特定领域的库,这也是每个公司不费力就能将英伟达集成进他们的产品路线图的原因。我们的特定领域库非常广泛。最后,我们为数据中心提供了端到端解决方案:InfiniBand网络、以太网、x86、ARM……几乎提供了技术解决方案和软件堆栈的所有组合。但真正将其结合在一起的,是一切架构都是兼容的,这是我们几十年前做出的一个很棒的决定。” [color=var(--print_on_web_bg_color, var(--color-primary))]客户喜欢即插即用的集成解决方案。例如,目前绝大多数收入是由英伟达强大的HGX平台驱动的。这就是微软的数据中心处理能力能够与英伟达同样出色的原因之一。这种将所有内容整合在一起的整体方法也使得扩展当前数据中心变得非常容易,这是LLM规模不断扩大的一个重要前提。 [color=var(--print_on_web_bg_color, var(--color-primary))]HGX平台是这样一个组合,基板上通过NVLink连接8个H100 GPU。32个这样的平台总共256个GPU可以联在一起形成一个单元。NVLink的带宽是最新一代PCIe的14倍,每秒能够传输900GB。 [color=var(--print_on_web_bg_color, var(--color-primary))]下图中,主板插入了6个A100 GPU,还有两个开放插槽,可以轻松插入服务器以连接CPU和网络接口卡(NIC)。 [color=var(--print_on_web_bg_color, var(--color-primary))]

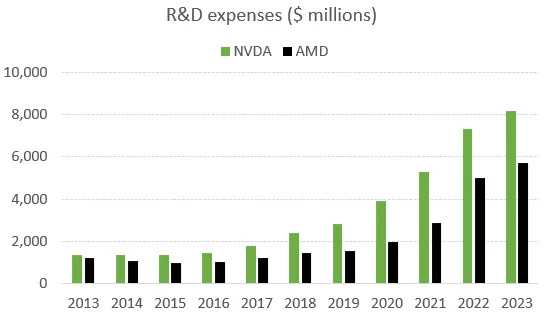

[color=var(--print_on_web_bg_color, var(--color-primary))]总之,英伟达不仅领先,而且持续在各个方面创新。即使是AMD或英特尔等主要竞争对手也无法跟上这种创新步伐,更不用说该领域的新来者了。比如英伟达研发支出超过了AMD,而AMD主要专注于CPU。意味着与AMD相比,英伟达可以将更多的研发资金集中在GPU上,因此这一领域的差距将更加明显。 [color=var(--print_on_web_bg_color, var(--color-primary))]

[color=var(--print_on_web_bg_color, var(--color-primary))]英伟达在推理市场的优势

[color=var(--print_on_web_bg_color, var(--color-primary))]到目前为止,英伟达的大部分GPU收入都是由AI训练所驱动。现在正进入下一阶段,经过训练的MML模型正要进入推理工作。英伟达的CFO介绍: [color=var(--print_on_web_bg_color, var(--color-primary))]“训练和推理是高度相关的,为了训练模型,你必须首先推理并计算误差,然后将误差应用到模型中,使其更智能。因此,训练的第一步是推理,因此客户在使用训练集群和HGX时一并会部署推理模型。我们的推理平台包含多种优化总拥有成本、工作负载和性能的选项。” [color=var(--print_on_web_bg_color, var(--color-primary))]要使推理成为一个巨大的市场,需要有愿意为AI助手或平台付费的庞大用户群。最有前途的是AI助手,它将MML模型内置到应用程序,在用户的命令下可以自动执行各种任务,从而提高生产力。例如,LLM可以生成新的软件代码,根据提供的信息创建新的演示资料,或创建各种Excel公式和进行运算。这使得员工可以广泛和更深度地使用软件。 [color=var(--print_on_web_bg_color, var(--color-primary))]另一个例子是可以在谷歌地图中内置LLM,可以显示城市旅行期间的最佳游览地点,还可以为用户预订合适的酒店和晚餐地点。这些助手中较小的可以在终端设备上运行,而较大的则可以在云中运行。因此除了OpenAI的GPT 4和谷歌Gemini等大型基础模型之外,企业都需要为其应用程序配合更小的定制化AI助手。 [color=var(--print_on_web_bg_color, var(--color-primary))]多年来,英伟达一直致力于进一步深化软件实力,因此不足为奇他们建立了一项定制化AI模型的服务。AI Foundry是一个云平台,客户可以在其中定制化英伟达提供的基础模型。这与亚马逊Bedrock非常相似。 [color=var(--print_on_web_bg_color, var(--color-primary))]黄仁勋提供了一些细节: [color=var(--print_on_web_bg_color, var(--color-primary))]“我们的盈利模式是,每个合作伙伴都在DGX Cloud上租用一个沙盒,我们一起工作。我们帮他们构建定制化AI。我们在云端、预置、任何地方都拥有庞大的安装基础。我们称之为英伟达AI Enterprise。商业模式基本上是软件许可,然后我们的客户在此基础上构建他们的盈利模型。” [color=var(--print_on_web_bg_color, var(--color-primary))]因此英伟达构建了一个针对AI加速进行优化的完整软硬件堆栈,客户可以利用平台在其上运行其定制的AI。英伟达在AI模型构建方面拥有强大的能力,梅赛德斯等汽车制造商现正在利用英伟达的平台开发自动驾驶系统。作为回报,梅赛德斯向英伟达提供了自动驾驶业务50%的收入分成。 [color=var(--print_on_web_bg_color, var(--color-primary))]英伟达副总裁Ian Buck对LLM的未来发展发表了如此看法: [color=var(--print_on_web_bg_color, var(--color-primary))]“GPT如此庞大的原因之一,它在人类理解语料库上进行训练。未来不会只有一种囊括一切的模型,将会有各种各样的专业化和创新的模型。LLM不一定只是人类语言,它也可以是生物学、物理学或材料科学的语言。我们正在看到涌现出一批专业化区域化的GPU数据中心。” [color=var(--print_on_web_bg_color, var(--color-primary))]可以推断英伟达在推理市场上也应该处于强势地位,当然一些主要竞争对手也能分食一些份额。因此,英伟达在这一块的市场份额不会像他们在AI培训80%的份额那样,但仍处于有利地位,可以占据很大一块市场。 [color=var(--print_on_web_bg_color, var(--color-primary))]AMD和英特尔仍远远落后

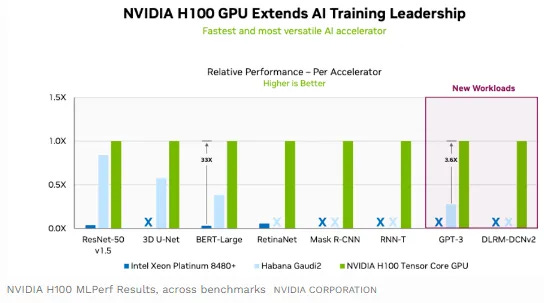

[color=var(--print_on_web_bg_color, var(--color-primary))]AMD确实一直在追赶,但他们在软硬件方面都远远落后。证明之一就是他们没有参加MLPerf基准测试,也没有得到任何订单。英特尔在MLPerf上一直在竞争,但通常会被英伟达硬件优势所碾压。今年早些时候这一权威的行业基准测试的结果如下所示。注意英特尔没有参加八项测试中的四项,说明了英伟达GPU的多用途性,它能够在每种类型的AI工作负载上生成最佳结果。 [color=var(--print_on_web_bg_color, var(--color-primary))]

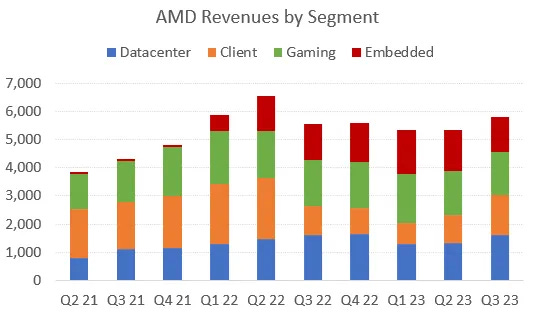

[color=var(--print_on_web_bg_color, var(--color-primary))]不过,最近英特尔再次参加GPT3测试,缩小了一些差距。来自福布斯的报道说:“我们认为Gaudi 2的性能相当出色,并且比英伟达更实惠、更可用。这些结果应该有助于为2024年推出的Gaudi 3铺平道路。当然届时英特尔将不得不与英伟达的下一代GPU B100(又名Blackwell)竞争。” [color=var(--print_on_web_bg_color, var(--color-primary))]因此,英特尔在GPT3上实现更好的性价比是一个很好的进步,但在多大程度上会使订单增长仍值得怀疑。英特尔在Q3电话会议上提到,他们的品类数量增加了一倍,但这是在极低的基数上。AMD稍微好一点,预计明年MI300 GPU的收入将达到20亿美元,但这与英伟达目前在数据中心GPU上每年产生560亿美元的收入相比,几乎是九牛一毛。 [color=var(--print_on_web_bg_color, var(--color-primary))]瑞银提到,AMD目前获得的订单为英伟达的10%。这样的份额对于AMD来说相当不错了,目前他们的MI300在HBM和带宽上具有优势,并且已经开始发货。英伟达将在未来12个月内发布两款GPU,这可能会再次压缩AMD的份额。 [color=var(--print_on_web_bg_color, var(--color-primary))]AMD的MI300将可能主要用于推理工作负载,苏姿丰在电话会议上也证实了这一点:“我们对MI300的推理性能非常满意,特别是对于LLM模型的推理,因为内存带宽和内存容量的优势。这对我们来说这是一个巨大的工作量。” [color=var(--print_on_web_bg_color, var(--color-primary))]显然,与英伟达相比,这两个竞争对手的份额仍然很小,未来两到三年很可能仍将如此。从长远来看,随着英特尔和AMD不断构建自己的软件堆栈,并构建更好、更通用的硬件,应该有空间在数据中心GPU市场上占据更大份额。也许他们真正需要的是加快AI创新的步伐,因为目前英伟达似乎是唯一一家真正能够构建适当的硬件来运行最新模型的公司。AI领域的快速创新对英伟达特别有利,但英特尔和AMD都拥有快速发展并跟上AI行业步伐的堆栈和规模。 [color=var(--print_on_web_bg_color, var(--color-primary))]来自定制芯片的威胁

[color=var(--print_on_web_bg_color, var(--color-primary))]超大规模云计算企业正在利用自身优势,提供定制化芯片解决方案来满足客户的AI需求。众所周知,谷歌有主要用于内部工作负载的TPU;亚马逊有Trainium和Inferentia,微软最近推出了Maia。通常,超大规模云计算厂商还会提供编译程序以便在他们的芯片上运行Pytorch代码。目前使用的这些芯片主要用于推理工作负载。英伟达的GPU仍然供不应求,因此英伟达GPU被分配用于训练,并在自己的芯片上运行推理。 [color=var(--print_on_web_bg_color, var(--color-primary))]当然,超大规模云计算企业财力雄厚,他们自身也会保持良好的创新节奏。例如,亚马逊将于明年发布Trainium 2和Inferentia 3。然而在创新节奏上还是比不上英伟达,比如谷歌每隔两年左右发布一款新的TPU,目前已是第五代,与英伟达竞争的能力仍很有限。 [color=var(--print_on_web_bg_color, var(--color-primary))]亚马逊最近在有关其芯片进展时如此表示乐观情绪:“由于目前GPU供应短缺,Trainium和Inferentia的吸引力相对提高了,因为它们有更好的性价比,而且可以随时买到。很多LLM提供商对这些芯片有很强的兴趣。Anthropic决定在Trainium上训练LLM模型并使用Inferentia就是一个明证。然后是非常热门的初创公司Perplexity.ai也刚决定在Trainium和Inferentia上进行所有训练和推理。这就是两个例子。” [color=var(--print_on_web_bg_color, var(--color-primary))]目前的情况是,英伟达的竞争对手不断涌现,但英伟达在AI创新上的快节奏成了它的一大优势,如果保持持续的创新速度,一段时间内竞争对手很难追赶上。 [color=var(--print_on_web_bg_color, var(--color-primary))]英伟达之简单财务分析

[color=var(--print_on_web_bg_color, var(--color-primary))]显然,英伟达的数据中心收入已经爆炸式增长,管理层预期明年继续如此的增长态势。华尔街为英伟达的持续增长建模,假如对推理市场持牛市观点,那么英伟达以468美元的股价还是太便宜。 [color=var(--print_on_web_bg_color, var(--color-primary))]

[color=var(--print_on_web_bg_color, var(--color-primary))]例如以30倍PE和2026财年预计的EPS,则2025年年初的股价应为710美元。投资者可获得46%的年化回报率。然而,也有一种怀疑态度,认为英伟达未来一年的每股收益将达到周期峰值,随后将出现周期性修正。 [color=var(--print_on_web_bg_color, var(--color-primary))]从历史上看,英伟达的季度每股收益在经历一段时期的扩张之后出现过大幅回调。例如在上一次周期性低点期间,季度每股收益低到0.26美元左右。然而,LLM的突破将永久改变数据中心GPU的需求情况,因此不太可能回落到这种水平。最坏的情况是,周期底部的年度每股收益为3.5美元左右。然而,在这种情况下,市场会展望未来并开始预期周期性复苏,股价将出现市盈率扩张。 [color=var(--print_on_web_bg_color, var(--color-primary))]

[color=var(--print_on_web_bg_color, var(--color-primary))]总的来说,取决于你对人工智能的乐观程度,对英伟达看多是有利的。如果认为LLM将在全球的日常工作中变得普遍,那么英伟达值得买入。然而,如果认为GPU需求将在4-6个季度后出现急剧的周期性调整,那么看跌。 [color=var(--print_on_web_bg_color, var(--color-primary))]AMD之简单财务分析

[color=var(--print_on_web_bg_color, var(--color-primary))]AMD已成为一家多元化的半导体巨头,通过收购Xilinx,现在提供数据中心CPU和GPU、PC端CPU和GPU、游戏机GPU以及FPGA。 [color=var(--print_on_web_bg_color, var(--color-primary))]目前投行对2024年的收入增长做了38亿美元的测算,UBS认为AMD目前获得数据中心GPU订单的比例是英伟达的10%,那么可能会新增5至60亿美元的收入。这应该会使该股表现良好。然而,AMD股价已经偏贵,其交易价为2024年市盈率的26倍。 [color=var(--print_on_web_bg_color, var(--color-primary))]

[color=var(--print_on_web_bg_color, var(--color-primary))]总体而言,对于看好人工智能的人来说,AMD也是一个值得考虑的名字。该公司还拥有颇具吸引力的FPGA产品组合,该产品组合也应用于推理领域。2025年后AMD会提供更全面的软件解决方案以及更好的硬件产品和迭代节奏,竞争力将大大提升。 [color=var(--print_on_web_bg_color, var(--color-primary))]原文:[color=var(--print_on_web_bg_color, var(--color-primary))] Nvidia, AMD, and the AI cycle

[color=var(--print_on_web_bg_color, var(--color-primary))]声明: [color=var(--print_on_web_bg_color, var(--color-primary))]本人非投资顾问,所提供信息仅供决策参考,不构成投资建议。 [color=var(--print_on_web_bg_color, var(--color-primary))]原始资料来自网上,由作者分析综合,不能保证准确性和完整性。 [color=var(--print_on_web_bg_color, var(--color-primary))]文中包含的预测/判断基于对市场状况的多项假设,无法保证实现预期结果。

[color=var(--print_on_web_bg_color, var(--color-primary))]老猫美股研究 is a reader-supported publication. To receive new posts and support my work, consider becoming a free or paid subscriber.

|