GPU这门生意及英伟达之妒(上)GPU这门生意及英伟达之妒(上)2023年,全世界的公司和国家都在排队恳求英伟达,希望能买到更多的GPU,这种爆炸式的需求会持续下去吗?GPU市场的现有形态如何?会不会出现挑战者?2023年,全世界的公司和国家都在排队恳求英伟达,希望能买到更多的GPU,这种爆炸式需求会不会持续下去?GPU市场的现有形态如何?会不会出现挑战者?

[color=var(--print_on_web_bg_color, var(--color-primary))][url=][/url]

[color=var(--print_on_web_bg_color, var(--color-primary))][url=][color=var(--color-secondary-themed)]分享Share

[/url]

这篇文章的作者来自科技风险投资基金Founders Fund(创始人为Peter Thiel)的合伙人John Luttig,他一年只写了两篇文章,每一篇都是有影响力的重磅。这篇文章的作者来自科技风险投资基金Founders Fund(创始人为Peter Thiel)的合伙人John Luttig,他一年只写一两篇文章,每一篇都是有影响力的重磅。 11月份的这篇文章,全景式分析了GPU市场现有的主要玩家、需求方,潜在的竞争对手。对于了解我们GPU市场供需状况,做出投资决策非常有帮助。11月份的这篇文章,全景式分析了GPU市场现有的主要玩家、需求方,潜在的竞争对手。对于我们理解GPU市场供需状况,做出投资决策非常有帮助。

作者认为,AMD是英伟达强劲的竞争对手,对英伟达芯片的需求可能会在2-3年内持续。作者认为,AMD是英伟达强劲的竞争对手,对英伟达芯片的需求可能会在2-3年内降温。 无论作者是否认同的观点,这是一篇理解市场现状的深度的好文。不管是否认同作者的观点,这是一篇理解市场现状的深度好文。 文章很长,我还是分两部分发布吧。文章非常长,我还是分两部分发布吧。

对于成千上万家现金充裕、急需增长的科技公司来说,面对突如其来的人工智能潮,最容易复制的事情就是大规模采购GPU,剩下的事以后再想。对于成千上万家现金充裕、急需增长的科技公司来说,面对突如其来的AI潮,最容易复制的事情就是大规模采购GPU,剩下的事以后再想办法。 英伟达因此被推上了AI造王者的地位,因为英伟达可以来决定到底是什么资格大规模购买其前沿的H100 GPU。有数十家公司纷纷投入到转售GPU的业务中,从现在开始的GPU就是中渔利。英伟达因此被推上了AI造王者的地位,因为英伟达可以来决定,到底是谁才有资格大规模购买其前沿的H100 GPU。有几十家公司纷纷投入到转售GPU的生意中,从现在的GPU短缺中渔利。 对英伟达GPU的指数级需求增长是否会继续超过其供应?回答这个问题不太容易了,因为我们很难穿透市场恐慌和舆论战的噪音,洞察实际发生的供需形势。对英伟达GPU的指数级需求增长是否会继续超过其供应?回答这个问题已经不太容易了,因为我们很难透过市场恐慌和舆论战的噪音,去洞察实际发生的供需形势。 有几个因素增强了GPU的未知,了解这些因素将有助于我们了解2020年代将如何发展:有几个因素加剧了GPU的短缺,了解这些因素则将有助于我们了解2020年代将如何发展: [color=var(--print_on_web_bg_color, var(--color-primary))]打破英伟达GPU垄断的动机到了迫不及待的程度。多家厂商购买了数亿(甚至存储亿)美元的英伟达前沿芯片,硬件利润率赶超软件利润率,满足其定价能力的意愿比任何时候都更多强烈。打破英伟达GPU垄断的动机到了迫不及待的程度。多家厂商购买了数亿(甚至数十亿)美元的英伟达前沿芯片,硬件利润率赶超软件利润率,削弱其定价能力的意愿比任何时候都更强烈。 [color=var(--print_on_web_bg_color, var(--color-primary))]GPU购买者是一条很肥的长尾。GPU需求无法满足不仅仅是大型科技公司的问题。核心大型云平台企业(谷歌、微软和亚马逊)仅占英伟达H100销量的一半。从种子阶段的创业公司到国家,是一条长尾。GPU购买者是一条很肥的长尾。GPU需求无法满足不仅是大型科技公司的问题。核心的超大云平台企业(谷歌、微软和亚马逊)仅占英伟达H100销量的一半。从种子阶段的创业公司到国家,是一条长尾。 [color=var(--print_on_web_bg_color, var(--color-primary))]许多赶末思想驱动的GPU供应项目,其投资率并不明显。既无法自己制造GPU来避免英伟达的暴利,其长期需求也更加不稳定。这样的GPU购买者数以千计,而真正符合市场需求的基础模型数量却有限。有许多赶末班车心态驱动的GPU集群项目,其投资回报率并不明确。既无法自己制造GPU来避免英伟达的暴利,其长期需求也更不稳定。这样的GPU购买者数以千计,而真正符合市场需求的基础模型数量却和有限。 [color=var(--print_on_web_bg_color, var(--color-primary))]英伟达在繁荣-萧条周期下运营。大型科技公司能够以复利增长,在历史上持续出现异常现象。但英伟达与其他大型科技公司不同,其增长故事一向是很动荡。英伟达在繁荣-萧条周期下运营。大型科技公司能够持续以复利增长,在历史上属于异常现象。但是英伟达与其他大型科技公司不同,其增长故事一向是很动荡。

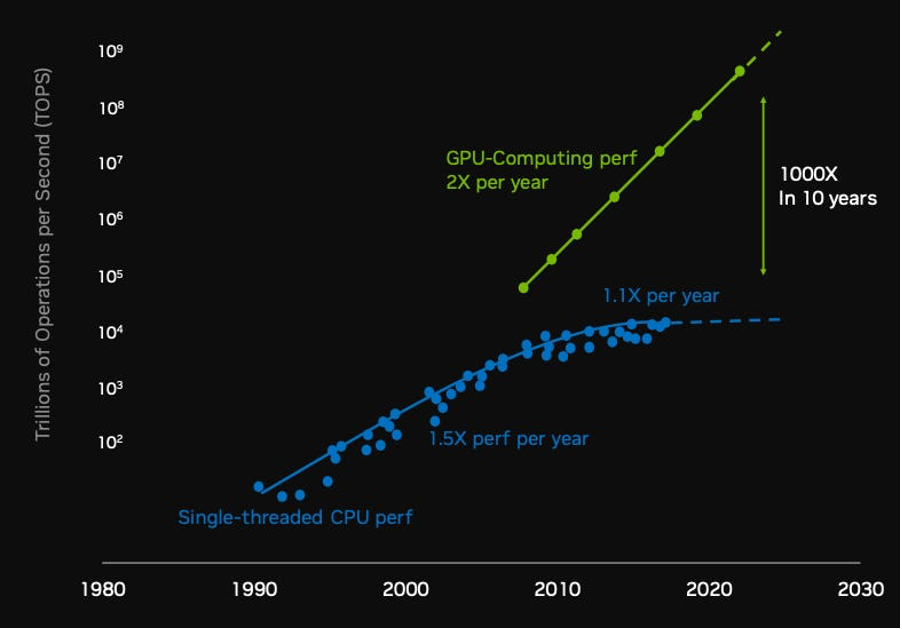

1.0为什么GPU那么重要?1.0 为什么GPU那么重要? GPU(即图形处理单元)最初开发于1970年代,用于快速执行视频游戏的图形显示。GPU的发展,使得摩尔定律得以起死回生。GPU(即图形处理单元)最初开发于1970年代,用于快速执行视频游戏的图形显示。GPU的发展,使摩尔定律得以起死回生。 CPU可以执行任何工作指令,GPU在硬件层面优化了指令。有了GPU,你可以同时执行数千个操作,而不是等待一个操作队列完成。证明,矩阵乘法不仅可以在屏幕上显示出立体动作,同样可以用于神经网络的训练和演算。CPU可以执行任何工作指令,GPU在硬件层面优化了并行指令。有了GPU,你可以同时执行数千个操作,而不是等待一个又一个操作排队完成。事实证明,矩阵乘法不仅可以在屏幕上展示出立体多边形,同样可以用于神经网络的训练和演算。 摩尔定律过去半个世纪一直在推进计算的极限。问题是2010年代它在CPU上已经无法再突破。每一美元获得的计算提升速度达到了极限,但由于GPU的产生,绝对计算性能的提升仍然令人惊叹。摩尔定律过去半个世纪一直在推进计算的极限。问题是2010年代它在CPU上已经无法再突破。每一美元获得的计算提升速度达到了极限,但由于GPU的产生,绝对计算性能的提升仍然令人惊叹。 计算极限一直在不断被突破。2010年,像GPT-4这样的模型在技术上是不可行的,当时最大超级计算机的计算能力实际上约1,000个H100。计算极限一直在不断被突破。2010年,像GPT-4这样的模型在技术上是不可行的,当时最大超级计算机的计算能力相当于约1,000个H100。 如果数据和计算的每一个数量级的增加,都会推动LLM智商水平的跃升,那么我们可以想象一下,下一个数量级会发生什么?如果数据和计算的每个数量级增加,会推动LLM智商级别的跃升,那么我们可以想象一下,下一个数量级会发生什么? [color=var(--print_on_web_bg_color, var(--color-primary))]

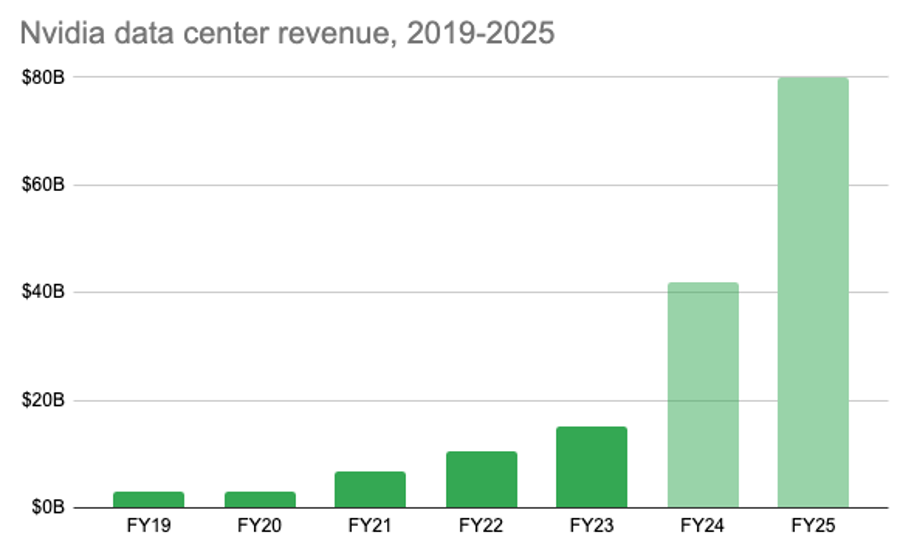

科技的指数级提升大部分只是S曲线,互联网采用率、广告支出、SaaS市场规模等,但计算提升可能是少数几个真正的指数级。假设到2043年我们再回顾2023年,那么我们现在的算力就是小菜一碟。科技的指数级提升大多数只是S曲线,互联网采用率、广告开支、SaaS市场规模等,但计算提升可能是少数几个真正的指数级。假设到2043年我们再回头看2023年,那么我们现在的算力就是小菜一碟。 2.0 AI造王者英伟达2.0 AI造王者英伟达 许多大型科技公司都制定了改善对英伟达的依赖的计划,但要在大模型的前沿竞争中,英伟达还是唯一的现实选择。许多大型科技公司都制定了计划来摆脱对英伟达的依赖,但要在大模型的前沿竞争,英伟达还是唯一的现实选择。 1993年成立的英伟达,当时想的是如何将3D图形导入游戏。他们于1999年发布了第一款GPU。1993年成立的英伟达,当时想的是如何将3D图形引入游戏。他们于1999年发布了第一款GPU。 2006年发明了CUDA,允许处理多个GPU,这样就形成了GPU集群,使训练更大的工作负载成为可能。2006年发明了CUDA,允许并行处理多个GPU,这样就形成了GPU集群,使训练更大工作负载成为可能。 他们在超级计算机领域占据垄断地位,为全球500个最强大的超级计算机中的74%,以及几乎所有的大型AI训练集群提供支持。英伟达最初只是一家面向消费者端的GPU公司,但现在是其业务核心是数据中心。他们在超级计算机领域处于垄断地位,为全球500个最强大超级计算机中的74%,以及几乎所有的大型AI训练集群提供支持。英伟达最初只是一家面向消费者端的GPU公司,但现在其业务核心是数据中心。 2.1 数据中心业务2.1 数据中心业务 用于AI和高性能计算的GPU的销售。今年第一季度销售收入达到170亿美元(占总收入的56%),第二季度翻了一番多,达到410亿美元(占总收入的76%) )。分析师预计2024年将又是辉煌的一年,数据中心收入将达到600-1000亿美元。销售用于AI和高性能计算的GPU。今年第一季度销售收入达到170亿美元(占总收入的56%),第二季度翻了一番多,达到410亿美元(占总收入的76%)。分析师预计2024年将是又一个辉煌的一年,数据中心收入将达到600-1000亿美元。 [color=var(--print_on_web_bg_color, var(--color-primary))]

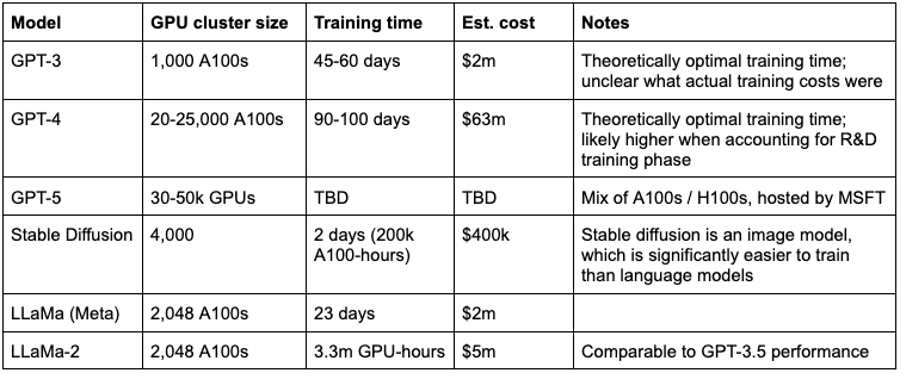

第二季度,英伟达数据中心收入大致为A100和H100各占一半。随着A100产量减少,天平正在迅速转向H100。对于训练大规模LLM(GPT-4级别),H100在速度(训练时间)和成本(每美元失败次数)两个方面都是最好的。截至第二季度,英伟达数据中心收入大约为A100和H100各占一半。随着A100产量减少,天平正在迅速转向H100。对于训练大规模LLM(GPT-4级别),H100在速度(训练时间)和成本(每美元失败次数)两方面都是最好的。 对于较小的语言模型和图像模型(如GPT-3或Stable Diffusion),A100(甚至更便宜的A10)则更高效。对于较小的语言模型和图像模型(如GPT-3或Stable Diffusion),A100(甚至更便宜的A10)则更经济高效。 假设模型训练到GPT-3级别,所需的计算量相对较低。你就明白为什么在ChatGPT推出短短几个月内,已有如此多的演示版本已经接近GPT-3的性能。 GPU集群有几十个,每个集群有一千多个A100就可以了。要将模型训练到GPT-3级别,所需的计算量相对较低。你也就理解了为什么在ChatGPT推出短短几个月内,就有如此多的演示版本已经接近GPT-3的性能。有几十个GPU集群,每个集群有一千多个A100就可以了。 对于GPT-4级别的性能,要求就很高。只有微软、亚马逊、谷歌和脸书等少数公司能够在单个集群中使用数万个最先进的GPU,更不用说如何跨过大规模数据采集和训练技术的承载了。大规模的数据采集和计算非常困难而且代价惨重。这就是为什么GPT-4发布的8个月后,还是没有企业能够超越它的通用性能。对于GPT-4级别的性能,要求就高得多。只有微软、亚马逊、谷歌和脸书等少数公司能够在单个集群中使用数万个最先进的GPU,更不用说如何跨过高质量数据采集和训练技术的门槛了。大规模数据采集和计算非常困难,而且代价高昂。这是为什么GPT-4发布的8个月后,还是没有企业能够超越它的通用性能。 这个图表应该让你了解训练各种模型所需的计算规模:此图表应该让你了解训练各种模型所需的计算规模: [color=var(--print_on_web_bg_color, var(--color-primary))]

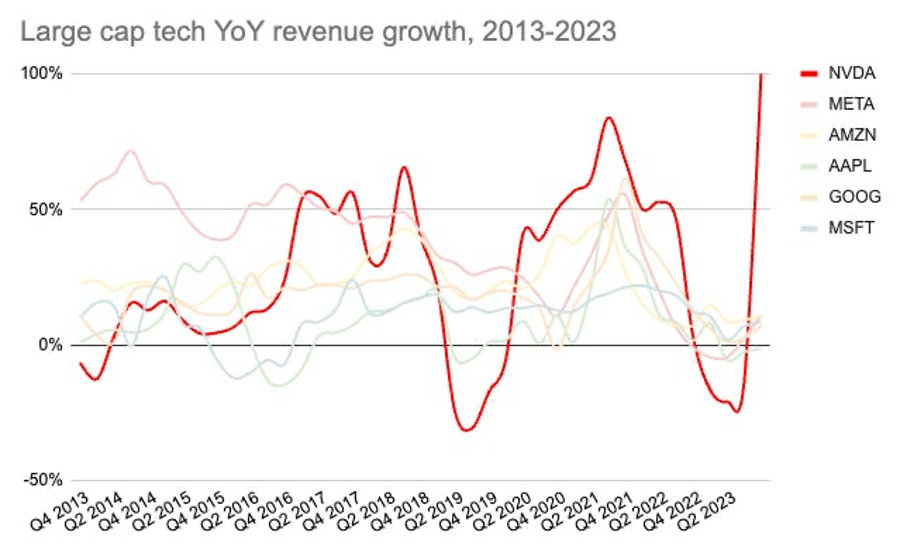

3.0 GPU需求曲线:增长还是过剩?3.0 GPU需求曲线:增长还是过剩? 2023年夏季,英伟达GPU的抢购已经很明显了。临近2023年夏季,H100已售出,订单排到2024年第一季度。2023年夏天,英伟达GPU的抢购已经很明显了。截至2023年夏季,H100已售罄,订单排到2024年第一季度。 我们不知道GPU何时结束,但我们可以通过了解当前的需求及发展方向,来大致确定得知的持续时间。我们不知道GPU短缺何时结束,但我们可以通过了解当前的需求及发展方向,来大致确定短缺的持续时间。 3.1 当下:谁在买GPU?3.1 当下:谁在买GPU? 其中下游参与者在大量购买英伟达GPU:大型云平台(谷歌、微软、亚马逊)、大型基础模型、创业公司和数量惊人的中型AI团队。有一批下游参与者在大量购买英伟达GPU:超大云平台(谷歌、微软、亚马逊)、大型基础模型开发商、创业公司和数量惊人的中型AI团队。 大型科技公司以运营为目的,需要大规模GPU集群。他们最适合培训自己的LLM模型,因为他们已经拥有高度专业的深度学习能力,对大型H100集群存在强烈的内部需求。核心的大型云平台( AWS、Azure、GCP)每年的资本支出均超过200亿美元,这个数字每年仍在以25%以上的速度增长。大型科技公司出于运营目的,需要大规模GPU集群。他们最适合培训自己的LLM模型,因为他们已经拥有高度专业的深度学习能力,对大型H100集群有着强烈的内部需求。核心的超大云平台(AWS、Azure、GCP)每年的资本支出均超过200亿美元,这个数字每年还在以25%以上的速度增长。 大玩家发起的支出资本竞赛,导致规模较小的云平台商必须跟上节奏:甲骨文的资本支出翻倍,从2021年的2.1亿美元增至2022年的4.5亿美元,再到2023年年8.7亿美元。大玩家发起的资本支出竞赛,导致规模较小的云平台商不得不跟上节奏:甲骨文的资本支出两次翻倍,从2021年的2.1亿美元增至2022年的4.5亿美元,再到2023年的8.7亿美元。 小型云平台都没有列出明确的 GPU 支出。初步估计,每个玩家将约 20-35% 的数据中心支出用于 GPU 的预计(GPU 采购、周边数据中心/供电等),其中微软最GPU为云服务带来的收入比例目前仍占比例,但增长迅速。粗略估计在5-15%范围,其中Azure发展最快。超大云平台都没有列明确切的GPU支出。业内人士估计,每个玩家将约20-35%的数据中心资本支出用于GPU的扩建(GPU采购、周边数据中心/供电等),其中微软最积极。GPU为云服务带来的收入比例目前仍然占很小比例,但增长迅速。粗略估计在5-15%范围,其中Azure发展最快。 每个超大规模云平台都有15多万个A100,单个集群多达约2.5万个GPU。但基本上暂停了A100的采购,转而购买下一代H100。最大的H100集群有2-3万个GPU(微软、脸书、亚马逊和谷歌),这些资源或在内部产品使用,或通过Azure/AWS/GCP对外租赁,或服务各自的AI合作伙伴(OpenAI、Inflection、Anthropic)。每个超大规模云平台都有15多万个A100,单个集群多达约2.5万个GPU。但基本上暂停了A100的采购,转而购买下一代H100。最大的H100集群有2-3万个GPU(微软、脸书、亚马逊和谷歌),这些集群或用在内部产品,或通过Azure/AWS/GCP对外租赁,或服务各自的AI合作伙伴(OpenAI、Inflection、Anthropic)。 其次一等级的GPU买家是Stability、特斯拉、Lambda Labs、Huging Face、Aleph Alpha和Andromeda这样的公司,他们的GPU集群包括数千个A100和H100。次一等级的GPU买家是Stability、特斯拉、Lambda Labs、Hugging Face、Aleph Alpha和Andromeda这样的公司,他们的GPU集群包括数千个A100和H100。 H100因为带宽和内存高,能够很好地服务于LLM培训。但对于一些类似的应用程序,如稳定扩散的图像生成模型、较小的训练模型(GPT-3规模)和LLM推理,则H100的性能就大材小用。 目前奥运这些AI案例能否扩大到用H100。H100因为高带宽和内存,能够很好地服务于LLM培训。但对于一些类似的应用程序,如Stable Diffusion的图像生成模型、较小的训练模型(GPT-3规模)和LLM推理,则H100的性能就显得大材小用。目前不清楚这些AI用例是否也会扩大到用H100。 3.2 中期:动荡将到来3.2 中期:动荡将不可避免 英伟达计划明年将H100的产量增加到200万以上(也有说300-400万)。市场需求有这么大吗?英伟达计划明年将H100的产量增加到200万以上(也有说300-400万)。有这么大的市场需求吗? 我们可以看一下购买者的需求:主流客户(超大云平台)和长尾客户。我们可以看一下两组购买者的需求:主流客户(超大云平台)和长尾客户。 超大型云平台商超大型云平台商 此类客户今年每个家都会存储数以万计的H100,从低端的2万张GPU集群,到高端的10万张GPU集群不等。微软是H100最大的一个客户,而谷歌要支持其内部TPU芯片的开发,一直加大H100的购买力度,以支持其2.6万个H100 A3集群。此类客户今年每一家都会储存数以万计的H100,从低端的2万枚GPU集群,到高端的10万枚GPU集群不等。微软是H100最大的一个客户,而谷歌要支持其内部TPU芯片的开发,也在加大H100的购买力度,以支持其2.6万个H100 A3集群。 英伟达在第二季度财报中披露,有一家云服务商占数据中心当季收入的29%,在2023年前6个月总共购买了3.9亿美元,约为13万个H100。我怀疑这是微软打提前量抢购的,以支持即将推出的 Office Copilot、OpenAI 计算和 Azure 服务。他们甚至通过 CoreWeave 和 Oracle 预留了多余的容量。如果 Office Copilot 导入,这就是一个灵活扩展 GPU 容量的明智做法,同时又防备如果需求稀疏的情况下能极大降低GPU资本超支的风险。英伟达在第二季度财报中披露,有一家云服务商占数据中心当季收入的29%,在2023年前6个月总计购买了3.9亿美元,相当于约13万个H100。我怀疑这是微软打提前量抢购的,以支持即将推出的Office Copilot、OpenAI计算和Azure服务。他们甚至通过CoreWeave和Oracle预留了多余的容量。如果Office Copilot起飞,这就是一个灵活扩展GPU容量的聪明做法,同时又防备如果需求减弱的情况下能极大降低GPU资本超支的风险。 超大云平台商约占所有H100需求的50%。他们的大规模采购,有很大一部分是为了支持即将推出的新产品,例如Office Copilot和Google Gemini。大型科技公司的LLM相关产品是否被市场接受,很大程度上是H100需求的先行指标。超大云平台商约占所有H100需求的50%。他们的大规模采购,有很大部分是为了支持即将推出新产品,例如Office Copilot和Google Gemini。大型科技公司的LLM相关产品是否被市场接受,很大程度上是H100中期需求的先行指标。 此类产品无疑将得到特定等广泛采用,但公司需要花时间去解决产品缺陷、探索的垂直案例,因此短期内难以证明对H100进行如此大规模的投入是合理的。为了让GPU投资获得回报,需要在Office的500亿美元收入基础上再增加至少10%,即收入超过50亿美元。此类产品无疑将得到广泛采用,但公司需要花时间去解决产品缺陷、探索特定的垂直用例等等,因此短期内难以证明对H100进行如此大投入是合理的。为了让GPU投资获得回报,需要在Office的500亿美元收入基础上再增加至少10%,即收入超过50亿美元。 长尾市场长尾市场 除了大型科技公司,还有谁在大量购买GPU?除了大型科技公司,还有谁在大量购买GPU? 大型科技公司投入使用H100的很大一部分(约30-50%)也将在云平台上使用,服务其大多数客户。这意味着H100总利用率的约2/3是长尾。大型科技公司投入使用的很大一部分H100(约30-50%)也将用在云平台上,服务其广大客户。这意味着H100总利用率的约2/3是长尾。 直接采购几千个到数千个H100的买家很多,比如Cloudflare、Palantir、HP、Voltage Park、Cohere,甚至沙特和队列。还没有购买GPU的人相当支出,向GPU所有者租用GPU的使用时间。直接采购几百到几千个H100的买家很多,比如Cloudflare、Palantir、HP、Voltage Park、Cohere,甚至沙特和阿联酋。还没有购买GPU的人也在花钱,向GPU所有者租用GPU的使用时间。 对于那些在自己的 GPU 上训练或高性能模型的玩家来说,集群利用效率通常很低。ChatGPT 福利一个例外,产品一推出就基本上实现了产品与市场的契合,保持了 GPU 的高利用率。对于那些在自己的GPU上训练或微调模型的玩家来说,集群利用效率通常很低。ChatGPT算是一个例外,产品一推出就基本上实现了产品与市场的契合,保持了GPU的高利用率。 大多数训练基础模型的公司不会像ChatGPT那么快地实现产品与市场的契合,要么是模型不够好,要么是产品不够好,要么是上市策略不够好。大多数训练基础模型的公司不会像ChatGPT那么快地实现产品与市场的契合,要么是模型不够好,要么是产品不够好,要么是上市策略不够好。 你会发现长尾的GPU需求是一个很大的疑问。问题是,如果AI的低投资回报率水落石出之后,不会有AI推理的需求替换补上。你会发现长尾的GPU需求是一个很大的疑问。问题是,如果AI训练的低投资回报率水落石出之后,会不会有AI推理的需求替补上。 3.3 需求的周期性3.3 需求的周期性 预测GPU需求的一个挑战是,英伟达的每一款产品都具有高度周期性和前置性。例如,在2020年A100发布仅三年后,英伟达就开始减少产量。预测GPU需求的一个挑战是,英伟达的每一个产品都具有高度周期性和前置性。例如,在2020年A100发布仅3年后,英伟达就开始减少产量。 虽然英伟达的GPU在2010年代开始主要用于游戏,但2017年和2020年加密货币的繁荣,极大地加速了其增长。随着加密货币开始近乎兼容,人工智能热潮在完美几乎的时机开始了:考虑一下达到更高质量的客户群并直接转化为生产力的投资回报,人工智能驱动的需求应该比加密货币挖矿的增长更持久。但由于 GPU 通常是非定期的资本支出购买,半导体因此行业历来都是一个繁荣与萧条轮回的行业。虽然英伟达的GPU在2010年代初主要用于游戏,但2017年和2020年加密货币的繁荣,极大地加速了其增长。随着加密货币开始降温,人工智能热潮在近乎完美的时机开始了:考虑到更高质量的客户群和直接转化为生产力的投资回报,人工智能驱动的需求应该比加密货币挖矿的增长更持久。但由于GPU通常是作为非定期的资本支出购买,因此半导体行业历来都是一个繁荣与萧条轮回的行业。 尽管现在看来英伟达有着惊人的指数式增长,但增长的不可预测性,有助于在大型科技公司中间成为收入最不稳定的家庭。尽管现在看来英伟达有着很棒的指数式增长,但增长的不可预测性,使它在大型科技公司中间成为收入最不稳定的一家。 [color=var(--print_on_web_bg_color, var(--color-primary))]

3.4 地理上的规模化3.4 地理上的规模化 英伟达有20%的需求来自中国。由于禁止向中国销售高性能GPU,许多中国科技公司一直在储备异常大量的芯片,以应对美国的出口管制。英伟达有20%的需求来自中国。由于禁止向中国销售高性能GPU,许多中国科技公司一直在储备异常大量的芯片,以应对美国出口管制。 中国科技公司百度、字节跳动、腾讯和阿里巴巴斥资10亿美元购买今年交付的芯片(主要是A800,外围控制的简化版A100),并斥资40亿美元购买2024年的芯片。由于中国市场的收入占20%(如果考虑到第三方的外围GPU采购,可能会更高),加强出口管制可能会在中坚对英伟达业绩造成较大阻力。中国科技巨头百度、字节跳动、腾讯和阿里巴巴斥资10亿美元购买将于今年交付的芯片(主要是 A800,绕开出口管制的简化版A100),并斥资40亿美元购买2024年的芯片。由于中国市场的收入占20%(如果考虑到经由第三方的绕道GPU采购,可能会更高),加强出口管制可能会在中期内对英伟达业绩造成重大阻力。

|