[color=rgba(255,255,255,var(--tw-text-opacity))]NVIDIA 的 GB200 可用于高达 27 万亿参数模型:扩展下一代 AI 超级集群[size=1.125]

2025 年 3 月 21 日 [img]https://images.prismic.io/bethtechnology/3998cc99-759f-4d20-8d4c-d4f9a1234670_IO+Fund+Logo+-+www.io-fund.com.png?auto=compress,format?w=256[/img]

投融资基金团队

[color=rgba(255, 255, 255, var(--tw-text-opacity))][size=1.25][color=rgba(255, 255, 255, var(--tw-text-opacity))][size=1.25][color=rgba(255, 255, 255, var(--tw-text-opacity))][size=1.25] [color=rgba(255, 255, 255, var(--tw-text-opacity))][size=1.25][color=rgba(255, 255, 255, var(--tw-text-opacity))][size=1.25][color=rgba(255, 255, 255, var(--tw-text-opacity))][size=1.25]

[size=1.125]超级计算机和尖端 AI 数据中心正在推动人工智能 (AI) 革命。大型系统需要日益集成的全面构建,以满足复杂工作负载不断变化的需求。随着 AI 应用变得越来越复杂,对不仅功能强大而且节能的基础设施的需求正在呈指数级增长。NVIDIA 的 GB200 等创新旨在提供下一代 AI 超级集群所需的可扩展性。 [size=1.125]在2025 年 NVIDIA GPU 技术大会(GTC)上,系统副总裁兼首席架构师 Mike Houston 和应用系统工程高级总监 Julie Bernauer 在 5 月 18 日的演讲“数据中心的下一代大规模计算”中讨论了大规模系统设计原则。 NVIDIA 的首款机架级产品是 GB200 超级芯片[size=1.125]NVIDIA Grace Blackwell 200 (GB200) 超级芯片结合了两个 Blackwell GPU 和一个 Grace CPU。这是 NVIDIA 的首款机架级产品。NVIDIA GB200 NVL72 是一款配置和机架级液冷 AI 计算平台,专为 AI 训练和推理而设计,可处理生成 AI 模型的多达 27 万亿个参数。GB200 包括 Grace Hopper 计算托盘、NVLink 交换机(机架中间连接所有 GPU 的连接器)和电缆盒(背面有数英里的电缆将所有东西连接在一起)等基本组件。该设计包括用于 InfiniBand(用于连接集群的高速网络)的量子交换机和用于以太网的频谱交换机。 AI 101:什么是集群和超集群?[size=1.125]集群 101:是由高速网络连接的独立计算机(称为节点)组成的网络。集群充当统一资源,因为它们是配置为协同工作的独立机器,可充当单个强大的计算系统。它们通常用于并行处理,将大型任务分解为分布在节点上的较小部分,从而实现比单台计算机更快的处理速度。节点的一个主要优点是高可用性,这意味着如果一个节点(计算机)发生故障,其他节点可以接管其工作负载,确保系统保持运行。高性能计算 (HPC) 集群用于研究、科学模拟和 AI 训练等任务。 [size=1.125]加入成千上万信任 I/O Fund 对人工智能、半导体、加密货币和广告技术的专业股票分析的投资者 — 免费注册! 点击此处! [size=1.125]超级集群 101:非常大的集群,可能由数百到数千个 GPU 通过多个数据中心组成。例如,Elon Musk 的 xAI 超级计算机 Colossus 由 100,000 个 NVIDIA GPU 驱动,绝对是一个超级集群。 [size=1.125]DGX 最初是用于 AI 的单机,后来逐渐演变为用于 AI 训练的集群。预训练可能涉及超级集群,但训练后仍可能涉及 16,000 个 GPU,这些 GPU 具有较小的设置,用于使用经过训练的 AI 进行微调和推理以回答问题。

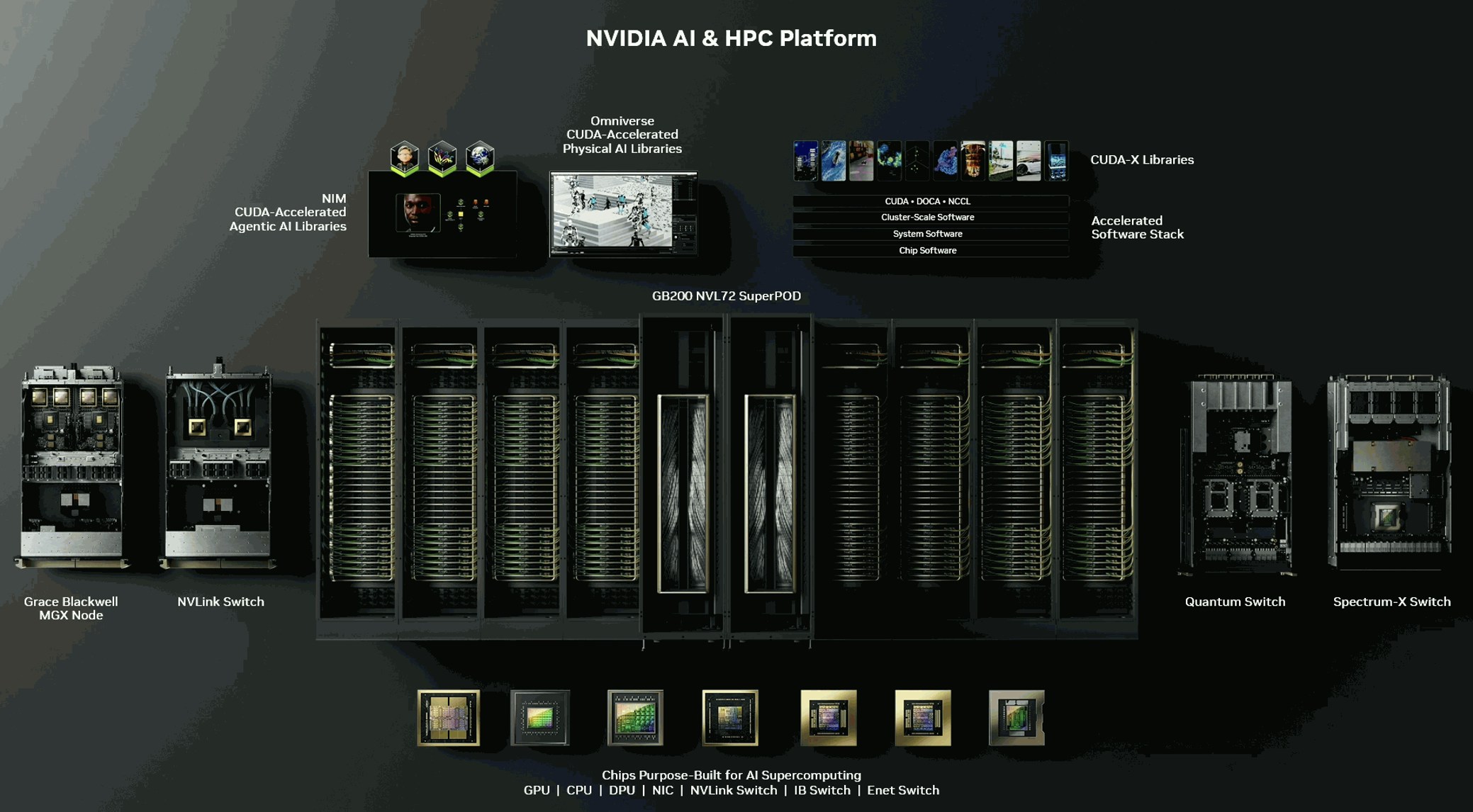

[size=1.125]NVIDIA AI 和 HPC 平台架构图,采用 GB200 NVL72 SuperPOD。

来源:NVIDIA 利用 GB200 充分发挥机架规模架构的优势[size=1.125]NVIDIA 的GB200 NVL72 是一个机架级系统。机架级将整个机架设计为一个大型、协调的单元,而不仅仅是将随机的机器粘在一起。机架级是指将可能跨多个服务器、存储和网络设备的系统集成和压缩到单个服务器机架上。GB200 可以替换或整合大量 GPU 计算服务器。这提供了许多好处,包括: - 提高 GPU 密度:GB200 NVL72 包含 72 个 Blackwell GPU 和 36 个 Grace CPU,它们通过 NVLink 互连,NVLink 是 NVIDIA 专有的高速 (130 TB/s) 信号互连,可使所有 72 个 GPU 和 36 个 CPU 充当单个大型 GPU。它旨在为大型语言模型 (LLM) 提供卓越的 AI 训练和推理性能。

- 性能:GB200 可提供高达 720 petaFLOP 的 AI 训练速度和 1.4 exaFLOP 的推理速度。由于所有组件都位于单个机架内,因此组件之间的通信延迟大大降低,这对于数据密集型任务尤其有益,可以减少瓶颈并提高数据吞吐量。

- 提高效率:机架级架构通过汇集资源来优化性能,从而更好地利用硬件。将资源整合到单个机架中可减少对单独单元的需求,从而节省数据中心的空间和电力。

- 更简便的管理:整个机架资源的集中管理简化了设置和维护,同时还支持扩展、配置和监控的自动化工具,以减少人工干预。

- 成本高效:更少的服务器、存储、网络设备、物理空间、冷却和能源使用量可以节省资金。正如 IO Fund 在其文章《AI 功耗:迅速成为关键任务》中讨论的那样,GB200“预计消耗 2,700W”,这会大幅增加运营费用,尤其是在没有机架级架构的情况下。

- 面向未来:机架级架构能够整合不断发展的技术,因为组件可以更换、修理和升级,从而更适应未来的发展。

- 统一电源和冷却:在单个机架内安装多个组件可降低冷却系统的复杂性并提高能源效率,从而降低运营成本。

利用 DGX SuperPOD、参考架构和结构扩展 AI 工厂[size=1.125]在 2025 年 NVIDIA GPU 技术大会 (GTC) 上,NVIDIA 发布了其下一代 DGX SuperPOD AI 基础架构。在“数据中心的下一代大规模计算”演讲中,系统副总裁兼首席架构师 Mike Houston 和应用系统工程高级总监 Julie Bernauer 谈到了 [size=1.125]SuperPOD 是 NVIDIA 的一体化 HPC 解决方案,旨在处理 AI 模型和模拟的大量计算需求。Grace Blackwell 节点是 SuperPOD 的构建块。在扩展集群和超级集群时,需要考虑三个因素。参考架构由预先测试的系统设计组成,可作为新数据中心部署的蓝图,以确保最佳安装和性能,从而加快第一个令牌的获取时间。 [size=1.125]Fabric 是指数据中心的网络基础设施,它连接所有服务器和设备,使它们能够无缝地相互通信,以减少组件(尤其是 GPU)之间的延迟。冷却对于大型数据中心至关重要。液体冷却是管理数千个 GPU 产生的热量的首选,因为它对于高密度平台来说效率更高。未来的 GPU 架构旨在实现更高的密度和更高效的连接,以突破 AI 计算的极限。 [size=1.125]I/O Fund 最近入股了 5 支新的中小型股,我们认为这些股票将成为这场 AI 支出战的受益者。每周四下午 4:30,我们都会在我们的 1 小时网络研讨会上讨论入场、退出以及对大盘的预期。在限定时间内,使用代码 PRO110OFF 可享受年度专业计划 110 美元的折扣[在此处了解更多信息]。

|