|

中型数据中心机房的规划与设计 信息化与数字化成为各个企业、行业提高速度、提高效率,获得效益的关键手段,而全球信息化与数字化的愈来愈成熟,为我们追求效益提供了方法、手段、标准。

(1)数字化:企业的业务、流程、经营、管理等等,相关活动全部进行数字化

(2)无纸化:过去基于传真、电话的定单模式不能适应数字化的要求,企业或组织的各种活动通过计算机网络自动进行,办公方式转为无纸化办公。

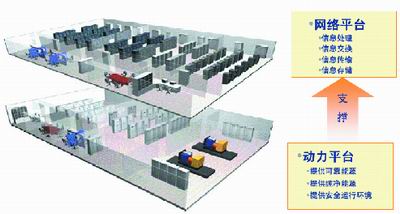

(3)集中化:分散的信息化不能形成规模效应,信息孤岛不能带来速度和效率提高。当前信息化的趋势是集中管理、集中存储、集中传输、集中交换,带来信息化的集中效应,这种集中效应表现在数据中心的兴起(如图1所示)。

图1 信息集中化的趋势,需要数据中心承载 1 数据中心的物理模型

数据中心的作用与目的是完成信息的集中管理、集中存储、集中传输、集中交换,从而实现信息集中效益。

在数据中心中,存在两个层面的平台:网络平台和动力平台(如图2所示)。

图2 数据中心(DC)物理模型的定义 2 数据中心的级别与分类:

根据美国TIA 942标准与Uptime Institute的定义,将数据中心的可用性等级分为四级(如表1所示):

表1

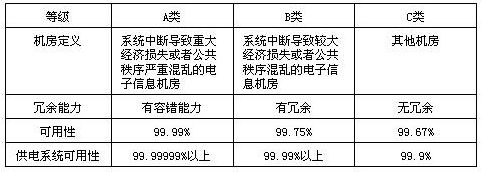

我国新制定的《电子信息机房设计规范》GB 50174-2008,将电子信息机房定义为A、B、C三类,其中A类要求最高(如表2所示)。

表2

按机房的规模,可以分为超大型数据中心、大型数据中心、中型数据中心和小型数据中心等。

◆ 超大型数据中心,通常面积大于2000m2,服务器机柜数量大于1000个;

◆ 大型数据中心,通常介于800~2000m2,服务器机柜数量200~1000个;

◆ 中型数据中心,面积为200~800m2,机柜数量为50~200个;

◆ 小型数据中心,面积为30~200m2,机柜数量为10~50个;

◆ 无专门场所的服务器/交换机机柜应用等。

以上规模划分是实际工作中的大致划分方法,并没有严格的划分标准与参照指标体系。划分的目的也仅仅是便于数据中心的规划、设计与建设等。

本文专门针对中型数据中心机房,探讨相关规划、设计与建设的标准、方法和实践。 3.1 机房选址

我国《电子信息机房设计规范》GB 50174-2008对机房选址提出了要求,综合美国数据中心标准TIA 942-2005,对数据中心选址可以参考以上标准。

实际工作中,对于中型数据中心机房的选址,用户通常选择与办公大楼等设施在一起,便于管理与维护。对于办公大楼来说,需要重点考虑以下内容:

(1)大楼的电力是否足够给数据中心使用。办公大楼在设计与建设的时候,主要面向人员办公需要,属于轻载荷的供电设计。而数据中心的设备供电量要求巨大,这样的重载荷设施放入办公大楼,常常会引起供电系统容量严重不足。无论是供电、亦或是制冷,都是对原有办公大楼用电容量的巨大挑战。

(2)是否有足够的空间,放置机房空调的室外机系统。办公大楼寸土寸金,面积利用率很高。而数据中心的机房需要恒温恒湿的机房专用系统,365天×24小时的不间断运行。机房专用空调如果采用直接制冷制式(DX),需要足够多的空间安装空调室外机。如果采用冷冻水系统,需要专门的365天×24小时运行的冷冻机组,而不能与大楼的中央空调系统混用。

(3)机房层高是否足够?办公大楼的层高为民用建筑设计,层高通常为2.8~3.2m。而数据中心需要安装静电地板,顶部吊顶。最佳层高(无障碍物)应该大于3.2m。

(4)是否有足够容量的载货电梯?通常的办公大楼载货电梯尺寸小、载荷低。而数据中心需要的UPS电源、机房空调等设备,都是大尺寸超重型设备。如果电梯不能运输,势必导致运输成本剧烈增加。

(5)在办公大楼设置数据中心,因为租金高昂、场地有限、供电不足,将严重限制数据中心的规模和安全级别。 3.2 规划与设计

中型数据中心机房的规划与设计,其需求源头来自于用户对服务器、软件系统的规划与需求。规划分为部分,包括容量规划(密度规划)、供电系统规划、制冷系统规划、网络规划等。

容量规划:容量是指中型数据中心机房的初期、终期的服务器等IT设备数量、或者面积。容量规划可以基于两个方面考虑,

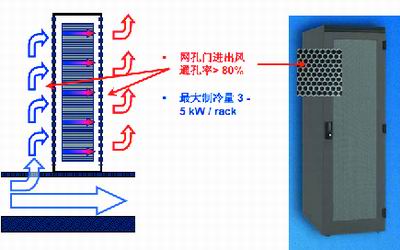

(1)数据中心机房的机柜数量×平均每机柜服务器数量。在采用普通地板送风制冷方式下,每个机柜的热密度为3~5kw/rack,超过这个热密度就必须采用高热密度的制冷解决方案(如图3所示)。

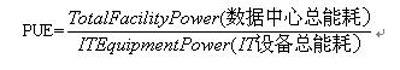

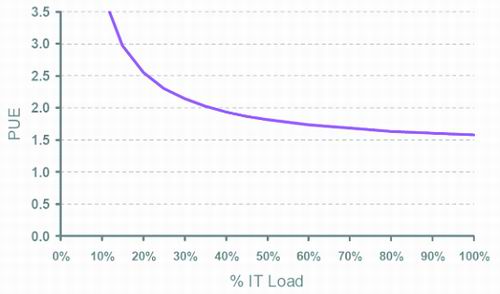

图3 传统开放式机柜+地板下送风制冷 (2)机房的电力供应。当机房的供电系统(市电+发电机)容量确定之后,可以计算出服务器的总功率。比如发电机最大容量为500kva,那么根据机房的能效PUE值(按2.0考虑),得出机房最大承载服务器容量为250kva(如图4所示)。 PUE能量使用效率的定义: Power Usage Effectiveness。

图4 PUE指标曲线 3.3 供电系统的规划与设计

当中型数据中心机房的最大容量确定后,用户可以根据预算、机房重要程度,结合《电子计算机机房设计规范》GB 50174-2008和美国TIA 942-2005的标准,确定供电系统与制冷系统。

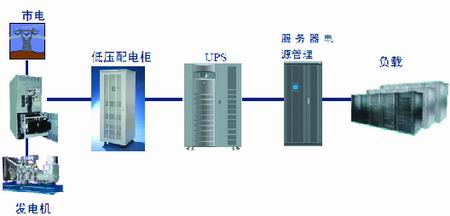

对于供电系统,包括从市电、发电机到配电、UPS、输出配电、服务器电源管理系统(列头柜)、机柜PDU等一系列环节(如图5所示)。

图5 数据中心供电系统示意图 上述标准列出了N、N+1、2N、2(N+1)等冗余方式。

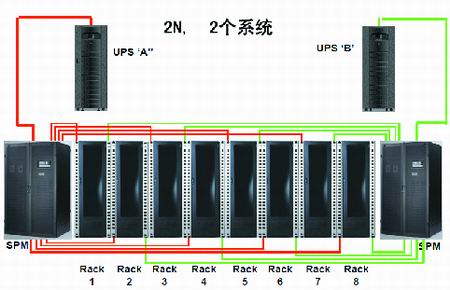

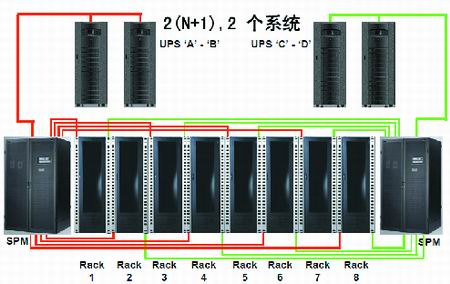

在中型数据中心机房的市电、发电机等系统,用户可以根据实际情况选择N+1或者2N系统。而UPS供电系统,建议用户采用2N或者2(N+1)方式,确保供电可靠性(如图6、7所示)。

图6 2N式供电系统

图7 2(N+1)式供电系统 用户选择UPS时,建议采用高频式UPS,因为采用高频IGBT整流+无隔离变压器式设计,输入功率因数高、输入电流谐波小、功率密度高等特点。同时因为UPS占地面积小重量小,搬运方便。

UPS的电池容量建议根据市电与发电机系统配置,通常为30分钟左右。一般不建议超过2小时的电池配置,重量大、成本高,投资不经济。

在UPS之后,需安装服务器电源管理系统SPM(又叫列头柜),为服务器机柜提供配电与保护。为提供服务器电源的配电可靠性,建议每一个配电回路都采用监控与管理系统,监控每一路回路的电流、电压、功率、功率因数、谐波、电量等参数,实现配电的安全管理和成本的细致化管理(如图8所示)。

3.4 制冷系统规划与设计

制冷系统是机房另外一个关键的基础设施。在中型数据中心机房,制冷系统设计包括:地板下送风系统、服务器机柜、机房专用空调等。

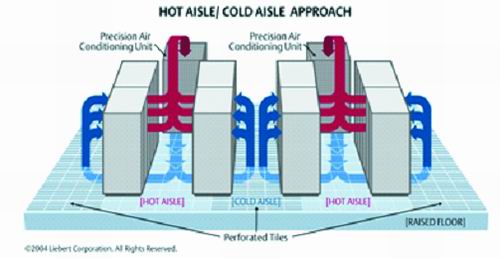

按照机房节能设计实践和标准,通常采用地板下送风、机柜布置按冷热通道方式,是制冷效率比较高的设计方式(如图9所示)。

图9 地板下送风+冷热通道设计 机房的服务器机柜也是制冷的关键之一。在很多运行的机房中,不少用户对机柜不重视,通常采购一些廉价服务器机柜。而这样的机柜必然带来通风面积小、服务器发热等问题。TIA 942标准规定机柜的通风面积比通孔率大于50%。而当服务器的热密度达到4kw左右是,建议用户采用通孔率大于70%的服务器机柜,确保服务器等IT设备通风量、风速正常。

此外,为了冷热通道隔离,建议使用挡板,将服务器机柜上空闲的U空间挡住,减少冷空气与热空气的无效热交换。

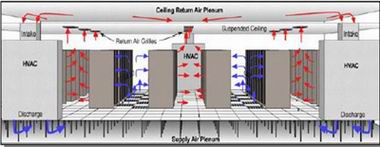

进一步的节能设计包括完全封闭的冷通道,实现冷空气与热空气的完全隔离。当然这样封闭式冷通道(或热通道设计),必须符合消防防火等规范(如图10所示)。

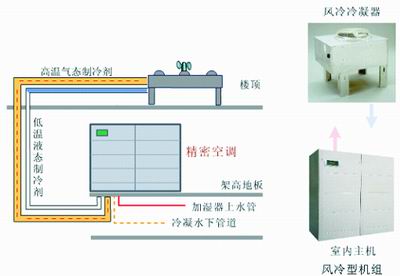

考虑到投资成本、运营成本、维护成本等,建议采用风冷式机房专用空调(DX式)。而水冷或者冷冻水式机房专用空调不适合于在中型机房中使用与推广(如11所示)。

图11 风冷式机房专用空调(DX式) 风冷式机房专用空调,按照上述标准,采用N+1(2或3)即可实现制冷系统较高的可靠性。在空调的供电上采取分组供电方式,避免单一供电回路导致的单点故障。 3.5 监控系统的规划与设计

中型数据中心机房的安全与运营监控管理是用户关注的核心内容之一。而这些数据中心机房通常采用无人值守工作模式,机房的安全与运营监控是无人值守的重要手段和工具。它包括:

机房视频监控系统。视频监控实现机房365天×24小时监控下运行,任何故意或无意的破坏都将记录在案。

机房设备与环境的监控系统。根据标准,必须实时监控机房的温度、湿度、水浸、供电系统工作参数与状态、空调系统工作参数与状态等,并在故障下主动提示用户采取措施,及时修复故障,确保机房安全稳定运行(如图12所示)。

图12 数据中心的机房监控系统 特别需要说明的是,中型数据中心机房通常不会配置电源专业人员,日常的管理与维护工作通常外包给专业类公司,IT用户仅仅督导与监控系统的运营维护工作。

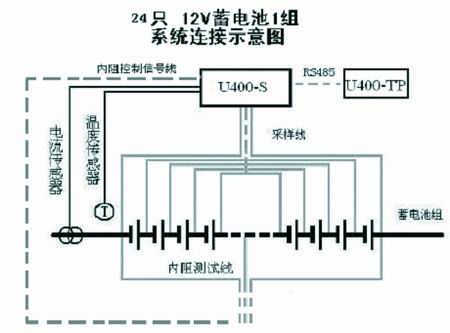

而在众多设备与环境中,电池的监控是比较容易忽视的环节。但是电池恰恰又是系统最后的安全保障,所以对电池的监控建议采用单体电压、单体内阻监控系统,实时在线监控电池的电压与阻抗变化,及时找出弱化电池与系统短木板。

TIA 942和GB 50174-2008也建议在最重要一级机房,实现对电池组中每一个电池单体电压、单体阻抗的监控。确保系统中所有环节都处于监控之下,实现系统的安全可靠运行。电池单体电压与内阻监控系统图(如图13所示)。

图13 电池单体电压、内阻监控示意图 |